-

处理器

-

服务器

-

模组&卡

TPU处理器

RISC-V处理器

深度学习视觉处理器

-

-

-

-

-

-

-

-

-

-

-

-

-

-

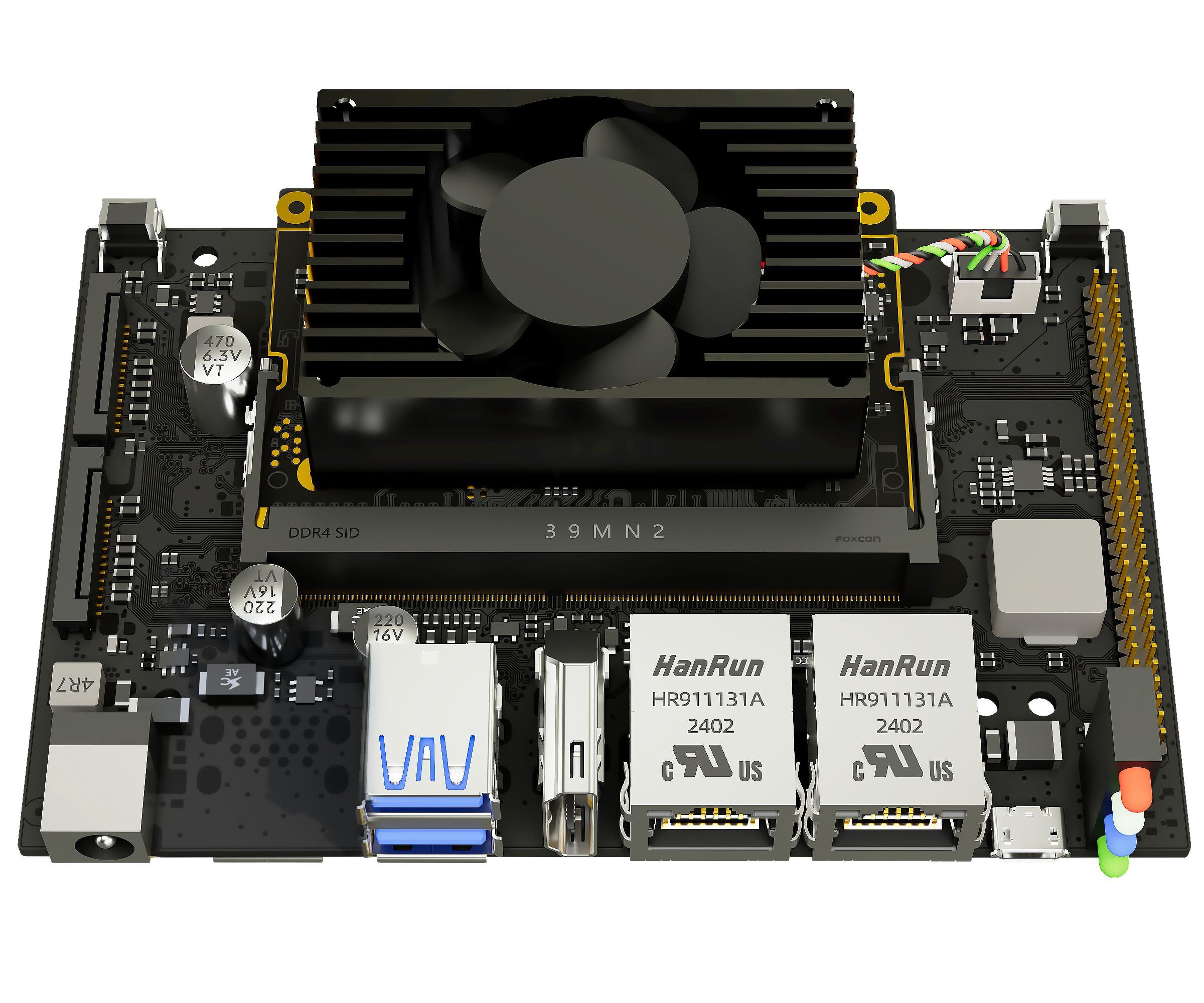

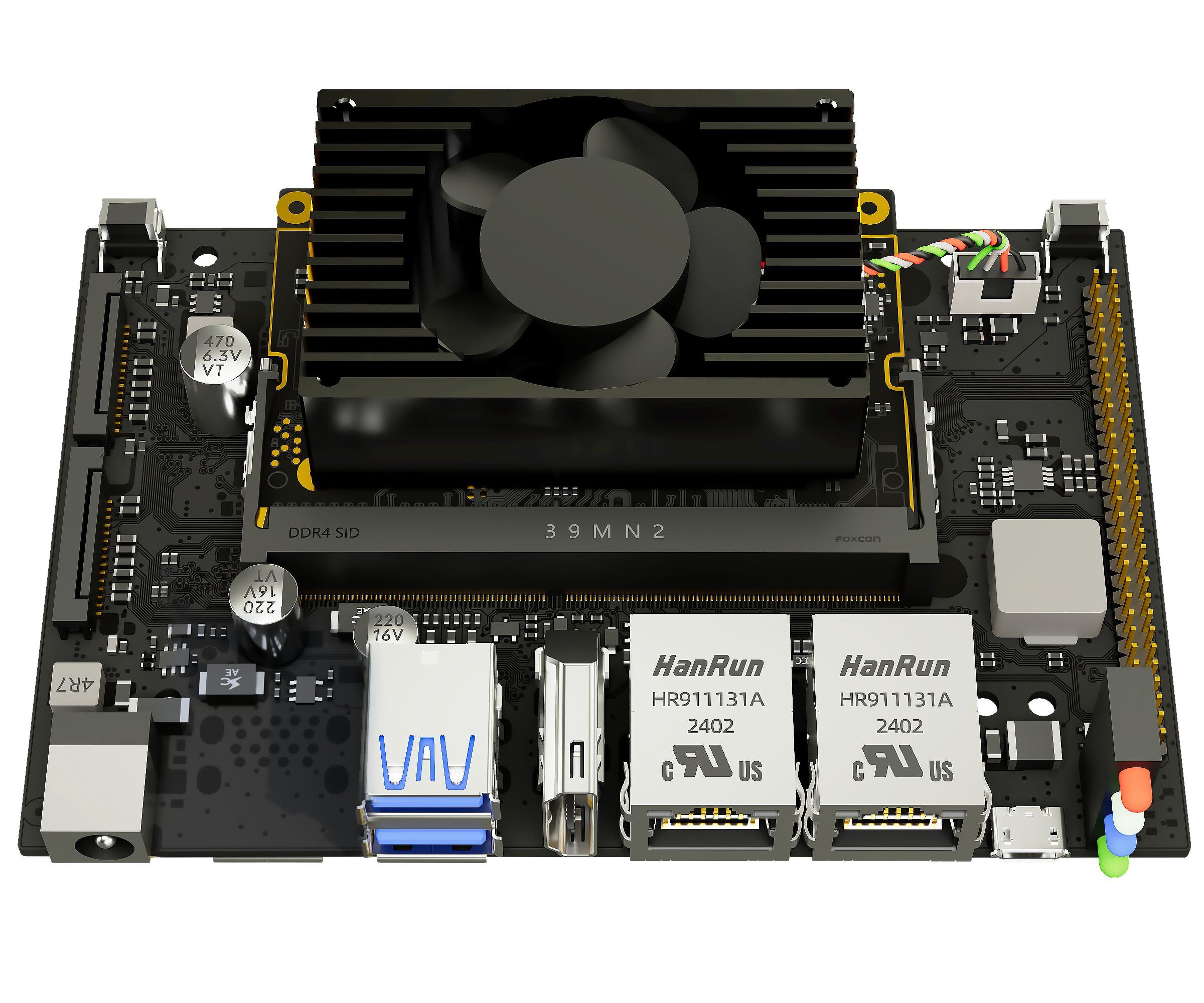

RISC-V 融合服务器 SRM1-20

RISC-V 融合服务器 SRM1-20RISC-V融合服务器,支持双芯互联、智能计算加速,软硬件自主可控,适配多场景高效计算需求。

-

-

-

RISC-V 计算服务器 SRA3-40

RISC-V 计算服务器 SRA3-40SRA3-40是一款面向高性能计算的RISC-V通用服务器,国产主控具备强劲性能,融合智算,支持强编解码。

-

RISC-V 存储服务器 SRB3-40

RISC-V 存储服务器 SRB3-40SRB3-40是一款高性能的RISC-V存储服务器,多盘位大容量安全存储。

智算模组

-

-

-

-

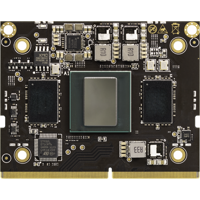

智算模组SM7 QY-AIM32T-M

智算模组SM7 QY-AIM32T-M智算模组SM7M,支持FP32/FP16/INT8,可同时进行32路高清视频解码与智能分析。

-

-

-

-

-

-

模组

-

板卡

-

开发者套件

-

算力整机

-

深度学习模组

深度学习模组SOM1684,搭载算能BM1684,支持16路高清视频分析

-

深度学习核心板

深度学习核心板Core-1684-JD4,搭载算能BM1684,支持16路高清视频分析

-

深度学习计算模组

深度学习计算模组SBC-6841,搭载算能BM1684,支持16路高清视频分析

-

深度学习核心板

深度学习核心板iCore-1684XQ,搭载算能BM1684X,支持32路高清视频分析

-

深度学习核心板

深度学习核心板Core-1684XJD4,搭载算能BM1684X,支持32路高清视频分析

-

开源硬件开发板

开源硬件开发板Shaolin PI SLKY01,搭载算能BM1684,支持16路高清视频分析

-

深度学习模组

深度学习模组QY-AIM16T-M,搭载算能BM1684,支持16路高清视频分析

-

深度学习模组

深度学习模组QY-AIM16T-M-G,搭载算能BM1684,支持16路高清视频分析

-

深度学习模组

深度学习模组QY-AIM16T-W,搭载算能BM1684,支持16路高清视频分析

-

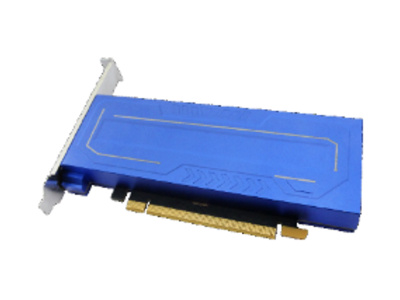

深度学习加速卡

深度学习加速卡AIV02T,PCIE板卡,1684*2,半高半长

-

深度学习工作站

深度学习工作站IVP03X,搭载算能BM1684X,支持32路高清视频分析

-

深度学习工作站

深度学习工作站IVP03A,微服务器 被动散热,12GB内存

-

边缘深度学习计算机

边缘深度学习计算机Coeus-3550T,搭载算能BM1684,支持16路高清视频分析

-

深度学习计算盒

深度学习计算盒EC-1684JD4,搭载算能BM1684,支持16路高清视频分析

-

深度学习1U集群服务器

深度学习1U集群服务器CSA1-N8S1684,算力集群服务器,BM1684*8,1U

-

电子封条分析装置

电子封条分析装置DZFT-ZDFX,ARM+DSP智能封条分析,搭载算能BM1684X

-

视频智能识别分析装置

视频智能识别分析装置ZNFX-32,搭载算能BM1684,支持16路高清视频分析

-

隔爆兼本安分析装置

隔爆兼本安分析装置ZNFX-8,ARM+DSP架构,隔爆兼本安分析装置符合煤安要求,搭载BM1684X

-

高算力深度学习主机

高算力深度学习主机EC-A1684JD4,微服务器主动散热,16GB内存,32GB eMMC

-

高算力深度学习主机

高算力深度学习主机EC-A1684JD4 FD,搭载算能BM1684,支持16路高清视频分析,16GB内存,32GB eMMC

-

高算力深度学习主机

高算力深度学习主机EC-A1684XJD4 FD,搭载算能BM1684X,支持32路高清视频分析

-

深度学习推理边缘计算盒

深度学习推理边缘计算盒ECE-S01,搭载算能BM1684,支持16路高清视频分析

-

禁限带物品智能分析设备

禁限带物品智能分析设备IOEHM-AIRC01,微服务器,主动散热,搭载算能BM1684,支持16路高清视频分析

-

深度学习视频采集分析设备

深度学习视频采集分析设备IOEHM-VCAE01,搭载算能BM1684,支持16路高清视频分析

-

深度学习 1U集群服务器

深度学习 1U集群服务器CSA1-N8S1684X,算力集群服务器,BM1684X*8,1U

-

深度学习服务器

深度学习服务器QY-S1U-16,1U版本BM1684盒子

-

深度学习 1U集群服务器

深度学习 1U集群服务器QY-S1U-192,算力集群服务器,BM1684*12,1U

-

深度学习 1U集群服务器

深度学习 1U集群服务器QY-S1X-384,算力集群服务器,BM1684X*12,1U

-

智慧政务

-

智慧交通

-

智慧公安

-

大物业

-

智慧商业

-

智慧生产

-

能源化工

-

智算中心

-

训推一体化

-

车辆大数据

为交通拥堵、行车安全、车辆违法和道路污染治理问题赋能

-

明厨亮灶

利用深度学习云边结合方式解决全域多家餐饮机构的食品安全监管需求,为政府、企业级公众打造监督闭环

-

通用安全生产

对生产全过程、全方位实时感知与精细化监管,推进应急监测智能化,赋能风险识别预警

-

智算中心

以云边协同的新型算力基础设施赋能各类数字城市场景,为数字经济发展提供源动力

-

深度学习算法训推一体化

以自动化训练推理一体化平台为基础,助力算力/算法整合应用快速、高效工程化落地